近赤外画像を用いた顔のリアルタイム位置合わせは,セキュリティ,医療,拡張現実など,様々な分野で重要な役割を果たしている.しかし、可視画像を用いて学習された既存の顔画像の位置合わせ手法は,近赤外の環境下で高い精度を達成することが難しかった.このような精度の低下は,可視と近赤外の波長による顔画像の違いや,正確にアノテーションされた近赤外の顔画像データセットが不足していることに起因している.

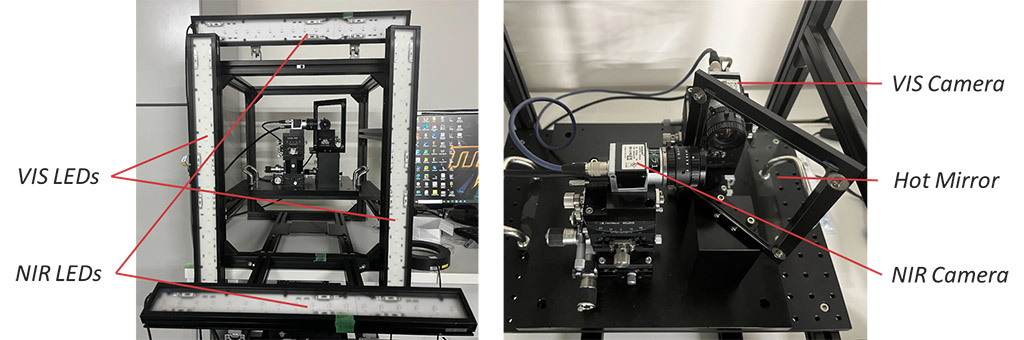

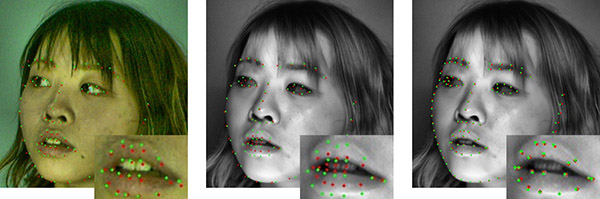

この問題を解決するために,可視画像に対して自動的にアノテーションされたランドマークを,同軸構成下で同時に取得された近赤外画像に転写することで,効率的かつ正確にデータを収集する方法を提案する.この方法のもと,我々は高フレームレートのペアの可視・近赤外の顔画像と対応するランドマークから成る新たなデータセット(100人から成る120万枚の顔画像+98点のランドマーク)を構築した.

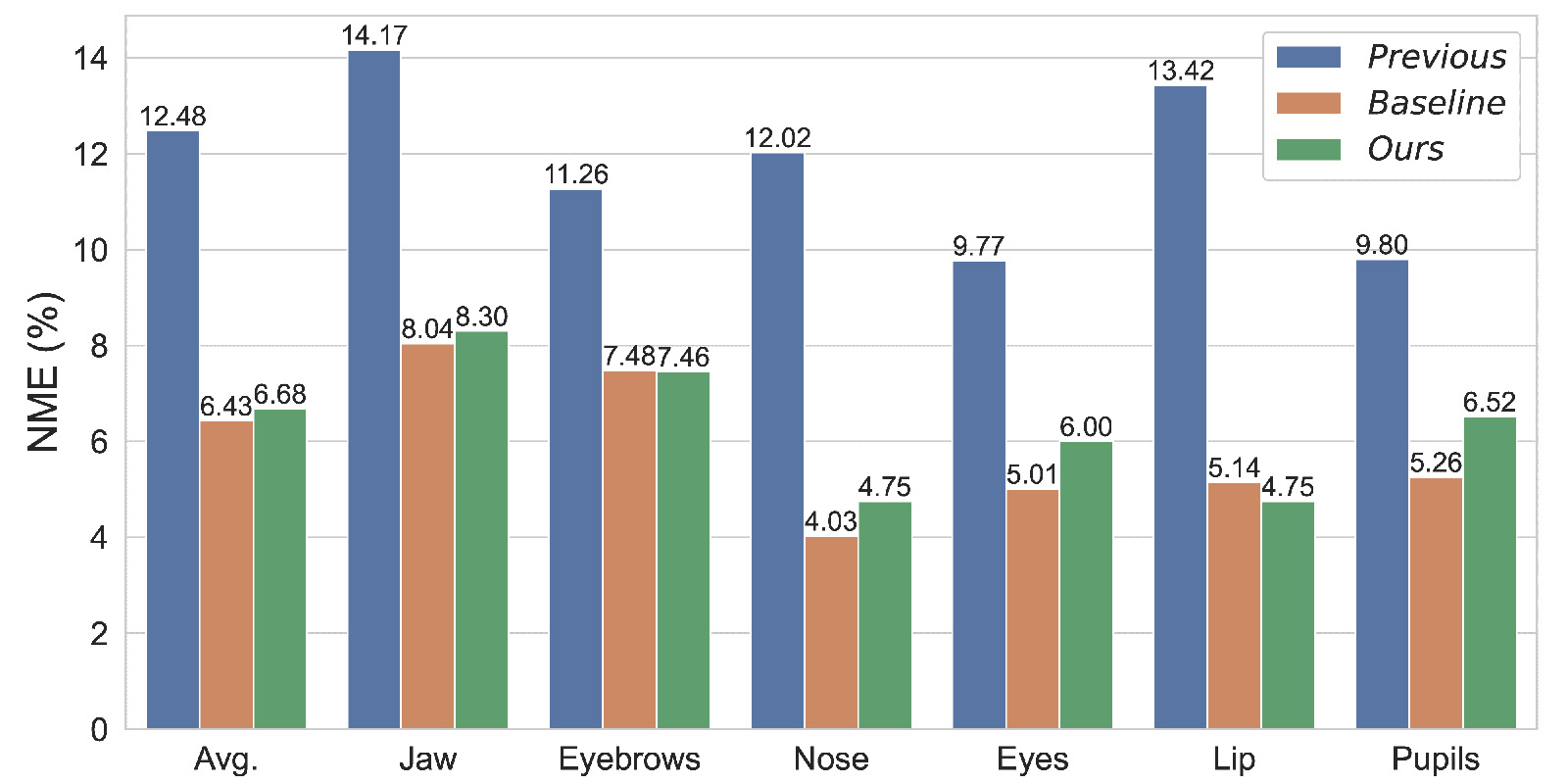

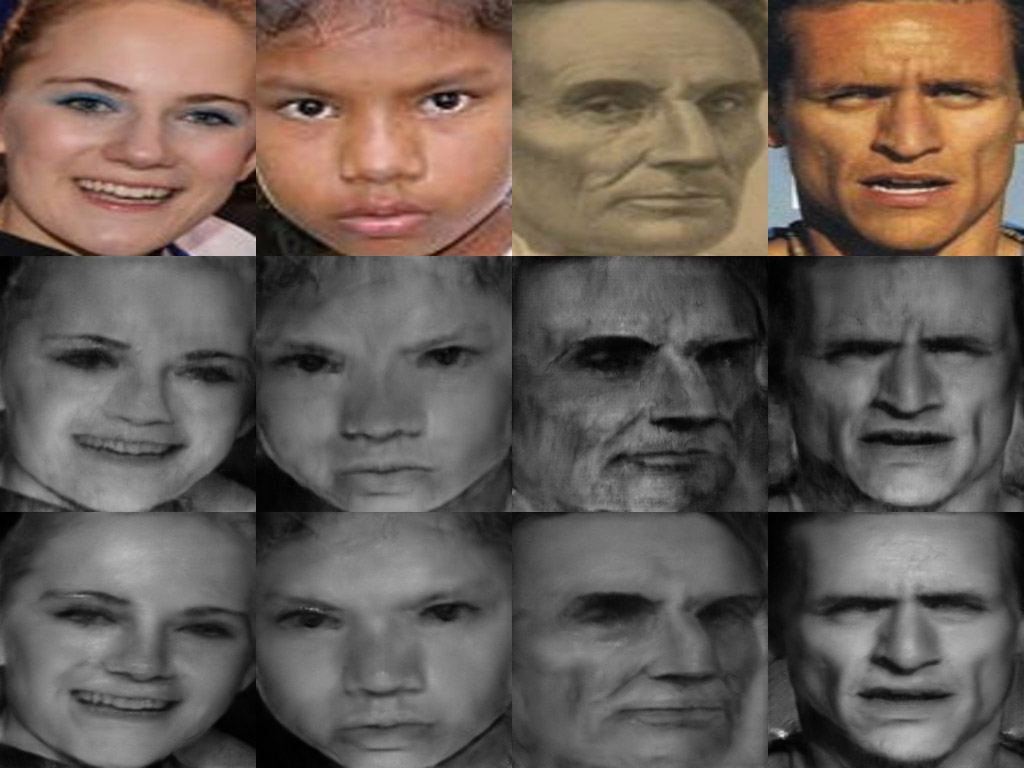

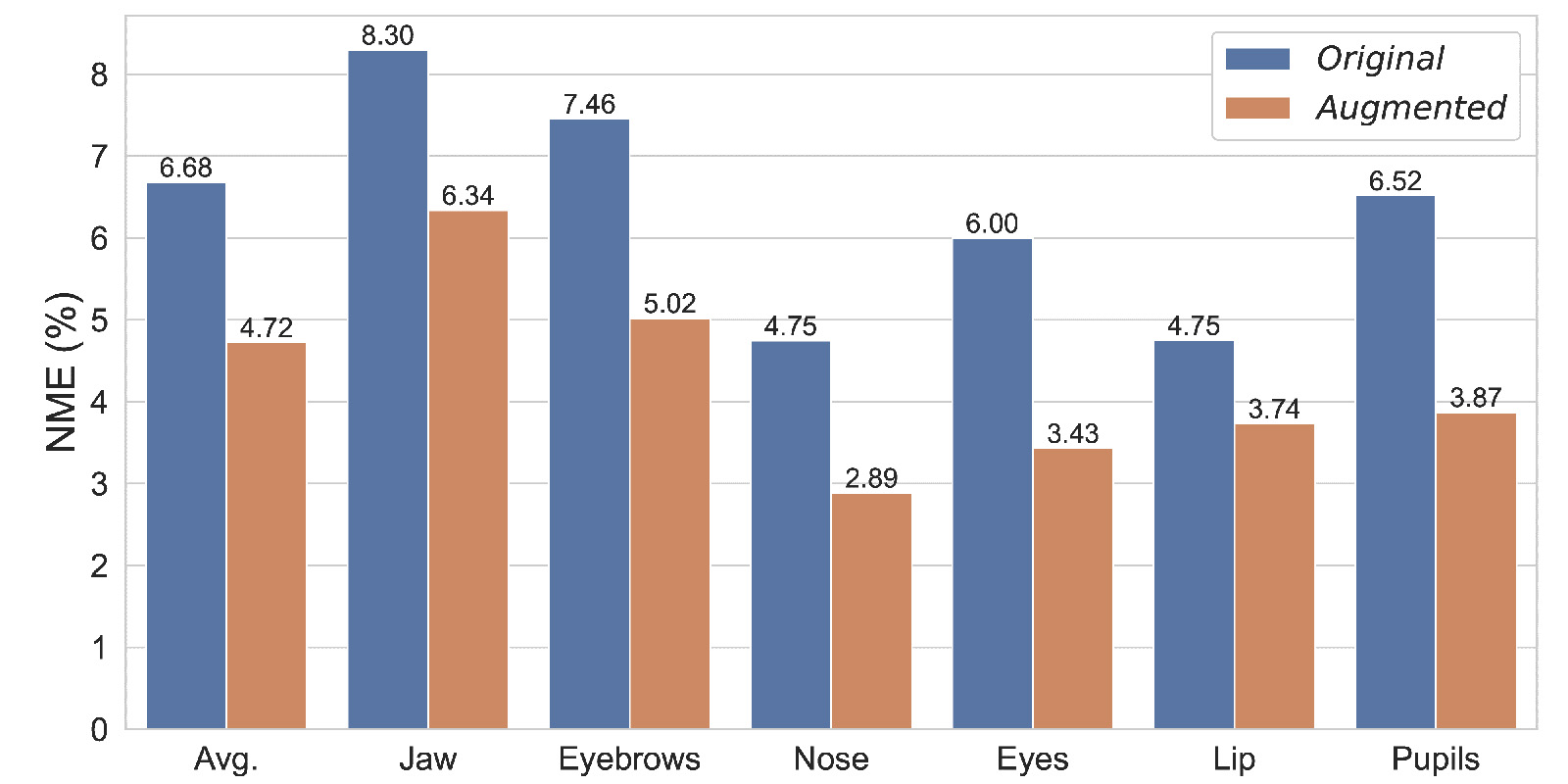

さらに,顔データの多様性を高めるために,我々のペア画像データセットを基に学習された可視から近赤外への画像翻訳によって,既存の公開されている可視の顔画像データセットを,近赤外の顔画像データセットとして拡張するアプローチを提案する.評価の結果,我々のデータセットを用いることで,近赤外下での顔画像の位置合わせ精度が従来よりも大幅に向上することを確認した.

参考文献

- Langning Miao, Ryo Kakimoto, Kaoru Ohishi and Yoshihiro Watanabe: Improving Real-Time Near-Infrared Face Alignment With a Paired VIS-NIR Dataset and Data Augmentation Through Image-to-Image Translation, 2024 IEEE International Conference on Image Processing (ICIP), pp. 2368-2374, doi: 10.1109/ICIP51287.2024.10648056, 2024.